El equipo Qwen de investigadores de IA del gigante chino del comercio electrónico Alibaba se ha convertido en el último año en uno de los líderes mundiales en el desarrollo de IA de código abierto, lanzando una serie de potentes modelos de lenguaje de gran tamaño y modelos multimodales especializados que se aproximan, y en algunos casos superan, el desempeño de los líderes propietarios de EE. UU., como OpenAI, Anthropic, Google y xAI.

Ahora el equipo de Qwen regresa esta semana con un lanzamiento convincente que coincide con el frenesí de “codificación de vibraciones” que ha surgido en los últimos meses: Qwen3-Coder-Siguienteun modelo especializado de 80 mil millones de parámetros diseñado para ofrecer un rendimiento agente de élite dentro de un espacio activo liviano.

Se lanzó con una licencia Apache 2.0 permisiva, lo que permite el uso comercial tanto de grandes empresas como de desarrolladores independientes, con la pesos de modelo disponibles en Hugging Face en cuatro variantes y una informe técnico describiendo algunos de sus enfoques de formación e innovaciones.

El lanzamiento marca una escalada importante en la carrera armamentista world por el asistente de codificación definitivo, luego de una semana en la que el espacio explotó con nuevos participantes. Desde las enormes ganancias de eficiencia del arnés Claude Code de Anthropic hasta el lanzamiento de alto perfil de la aplicación OpenAI Codex y la rápida adopción comunitaria de marcos de código abierto como OpenClaw, el panorama competitivo nunca ha estado más concurrido.

En este entorno de alto riesgo, Alibaba no sólo está manteniendo el ritmo: está intentando establecer un nuevo estándar para la inteligencia de peso abierto.

Para los tomadores de decisiones de LLM, Qwen3-Coder-Subsequent representa un cambio basic en la economía de la ingeniería de IA. Si bien el modelo alberga 80 mil millones de parámetros totales, utiliza una arquitectura de Mezcla de Expertos (MoE) ultraescasa que activa solo 3 mil millones de parámetros por paso directo.

Este diseño le permite ofrecer capacidades de razonamiento que rivalizan con los sistemas propietarios masivos, manteniendo al mismo tiempo los bajos costos de implementación y el alto rendimiento de un modelo native liviano.

Resolver el cuello de botella del contexto prolongado

El principal avance técnico detrás de Qwen3-Coder-Subsequent es una arquitectura híbrida diseñada específicamente para evitar los problemas de escala cuadrática que afectan a los Transformers tradicionales.

A medida que las ventanas de contexto se expanden (y este modelo admite la enorme cantidad de 262.144 tokens), los mecanismos de atención tradicionales se vuelven computacionalmente prohibitivos.

Los Transformers estándar sufren de un “muro de memoria” donde el costo de procesar el contexto crece cuadráticamente con la longitud de la secuencia. Qwen aborda esto combinando Gated DeltaNet con Gated Consideration.

Gated DeltaNet actúa como una alternativa de complejidad lineal a la atención softmax estándar. Permite que el modelo mantenga el estado en su ventana de un cuarto de millón de tokens sin las penalizaciones de latencia exponencial típicas del razonamiento a largo plazo.

Cuando se combina con el MoE ultraescaso, el resultado es un rendimiento teórico 10 veces mayor para tareas a nivel de repositorio en comparación con modelos densos de capacidad whole related.

Esta arquitectura garantiza que un agente pueda “leer” una biblioteca Python completa o un marco de JavaScript complejo y responder con la velocidad de un modelo 3B, pero con la comprensión estructural de un sistema 80B.

Para evitar alucinaciones de contexto durante el entrenamiento, el equipo utilizó Finest-Match Packing (BFP), una estrategia que mantiene la eficiencia sin los errores de truncamiento que se encuentran en la concatenación tradicional de documentos.

Capacitado para ser el agente primero

El “Siguiente” en la nomenclatura del modelo se refiere a un pivote basic en la metodología de entrenamiento. Históricamente, los modelos de codificación se entrenaban en pares de código-texto estáticos, esencialmente una educación de “sólo lectura”. En cambio, Qwen3-Coder-Subsequent se desarrolló a través de un proceso masivo de “entrenamiento agente”.

El informe técnico detalla un proceso de síntesis que produjo 800.000 tareas de codificación verificables. Estos no fueron meros fragmentos; eran escenarios de corrección de errores del mundo actual extraídos de solicitudes de extracción de GitHub y combinados con entornos totalmente ejecutables.

La infraestructura de formación, conocida como MegaFlow, es un sistema de orquestación nativo de la nube basado en Alibaba Cloud Kubernetes. En MegaFlow, cada tarea de agente se expresa como un flujo de trabajo de tres etapas: implementación del agente, evaluación y posprocesamiento. Durante la implementación, el modelo interactúa con un entorno contenedorizado en vivo.

Si genera código que falla una prueba unitaria o falla un contenedor, recibe retroalimentación inmediata a través del entrenamiento intermedio y el aprendizaje de refuerzo. Esta educación de “circuito cerrado” permite que el modelo aprenda de la retroalimentación del entorno, enseñándole a recuperarse de fallas y perfeccionar soluciones en tiempo actual.

Las especificaciones del producto incluyen:

-

Soporte para 370 lenguajes de programación: Una expansión de 92 en versiones anteriores.

-

Llamada de herramientas de estilo XML: Un nuevo formato qwen3_coder diseñado para argumentos con muchas cadenas, lo que permite que el modelo emita fragmentos de código largos sin las comillas anidadas y la sobrecarga de escape típica de JSON.

-

Enfoque a nivel de repositorio: La capacitación intermedia se amplió a aproximadamente 600 mil millones de tokens de datos a nivel de repositorio, lo que resultó más impactante para la lógica de dependencia entre archivos que los conjuntos de datos a nivel de archivo solos.

Especialización a través de modelos expertos

Un diferenciador clave en el proceso Qwen3-Coder-Subsequent es el uso de modelos expertos especializados. En lugar de entrenar un modelo generalista para todas las tareas, el equipo desarrolló expertos en dominios específicos para el desarrollo net y la experiencia del usuario (UX).

El experto en desarrollo net se centra en tareas completas, como la construcción de la interfaz de usuario y la composición de componentes. Todos los ejemplos de código se renderizaron en un entorno Chromium controlado por Playwright.

Para las muestras de React, se implementó un servidor Vite para garantizar que todas las dependencias se inicializaran correctamente. Luego, un modelo de visión-lenguaje (VLM) juzgó la integridad del diseño y la calidad de la interfaz de usuario de las páginas renderizadas.

Consumer Expertise Professional se optimizó para cumplir con el formato de llamada de herramientas en diversos andamios CLI/IDE, como Cline y OpenCode. El equipo descubrió que la capacitación en diversas plantillas de chat de herramientas mejoró significativamente la solidez del modelo frente a esquemas invisibles en el momento de la implementación.

Una vez que estos expertos alcanzaron el máximo rendimiento, sus capacidades se refinaron nuevamente en el modelo único MoE 80B/3B. Esto garantiza que la versión de implementación ligera preserve el conocimiento matizado de modelos docentes mucho más grandes.

Superando los puntos de referencia y ofreciendo alta seguridad

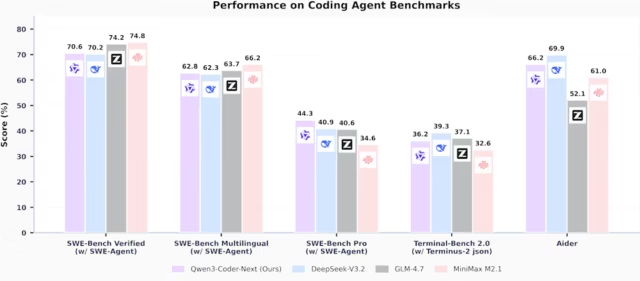

Los resultados de esta formación especializada son evidentes en la posición competitiva del modelo frente a los gigantes de la industria. En evaluaciones comparativas realizadas utilizando la plataforma SWE-Agent, Qwen3-Coder-Subsequent demostró una eficiencia excepcional en relación con su recuento de parámetros activos.

En SWE-Bench Verified, el modelo logró una puntuación del 70,6%. Este rendimiento es notablemente competitivo cuando se compara con modelos significativamente más grandes; supera a DeepSeek-V3.2, que obtiene una puntuación del 70,2%, y está sólo ligeramente por detrás de la puntuación del 74,2% de GLM-4.7.

Fundamentalmente, el modelo demuestra una sólida conciencia de seguridad inherente. En SecCodeBench, que evalúa la capacidad de un modelo para reparar vulnerabilidades, Qwen3-Coder-Subsequent superó a Claude-Opus-4.5 en escenarios de generación de código (61,2% frente a 52,5%).

En specific, mantuvo puntuaciones altas incluso cuando no se le proporcionaron sugerencias de seguridad, lo que indica que ha aprendido a anticipar los errores de seguridad comunes durante su fase de capacitación agente de 800.000 tareas.

En evaluaciones de seguridad multilingüe multilingüe, el modelo también demostró un equilibrio competitivo entre la generación de código funcional y seguro, superando a DeepSeek-V3.2 y GLM-4.7 en el punto de referencia CWEval con una puntuación func-sec@1 del 56,32 %.

Desafiando a los gigantes propietarios

El lanzamiento representa el desafío más importante para el dominio de los modelos de codificación de código cerrado en 2026. Al demostrar que un modelo con solo 3 mil millones de parámetros activos puede navegar las complejidades de la ingeniería de software program del mundo actual con tanta eficacia como un “gigante”, Alibaba ha democratizado efectivamente la codificación agente.

El “¡ajá!” El momento más importante para la industria es darse cuenta de que la duración del contexto y el rendimiento son las dos palancas más importantes para el éxito de la agencia.

Un modelo que puede procesar 262.000 tokens de un repositorio en segundos y verificar su propio trabajo en un contenedor Docker es fundamentalmente más útil que un modelo más grande que es demasiado lento o costoso de iterar.

Como concluye el equipo de Qwen en su informe: “Ampliar la capacitación de agentes, en lugar de solo el tamaño del modelo, es un issue clave para avanzar en la capacidad de los agentes de codificación en el mundo actual”. Con Qwen3-Coder-Subsequent, la period del modelo de codificación “mamut” puede estar llegando a su fin, reemplazada por expertos escasos y ultrarrápidos que pueden pensar tan profundamente como pueden correr.