Investigadores de Stanford, Nvidia y Collectively AI han desarrollado una nueva técnica que puede descubrir nuevas soluciones a problemas muy complejos. Por ejemplo, lograron optimizar un kernel de GPU crítico para que se ejecutara 2 veces más rápido que el estado del arte anterior escrito por expertos humanos.

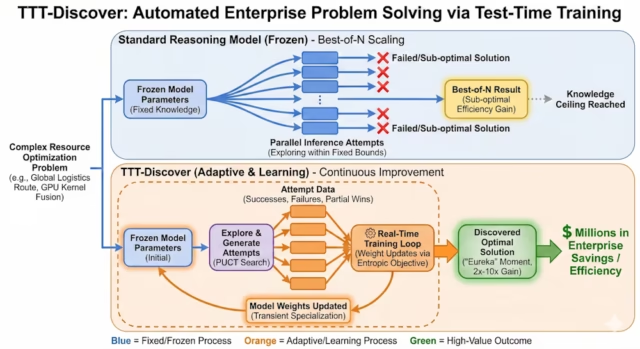

Su técnica, llamada “Entrenamiento en tiempo de prueba para descubrir” (TTT-Uncover), desafía el paradigma precise de permitir que los modelos “piensen más” para problemas de razonamiento. TTT-Uncover permite que el modelo continúe entrenándose durante el proceso de inferencia y actualice sus pesos para el problema en cuestión.

Los límites del razonamiento ‘congelado’

Las estrategias actuales de IA empresarial a menudo se basan en modelos “congelados”. Ya sea que utilice un modelo de razonamiento cerrado o abierto, los parámetros del modelo son estáticos. Cuando solicita a estos modelos, buscan respuestas dentro de la variedad fija de sus datos de entrenamiento. Esto funciona bien para problemas que se parecen a los que el modelo ha visto antes.

Sin embargo, los verdaderos problemas de descubrimiento, como inventar un algoritmo novedoso o demostrar un nuevo teorema matemático, están, por definición, fuera de distribución. Si la solución requiere un salto de lógica que no existe en el conjunto de entrenamiento, un modelo congelado probablemente fallará, sin importar cuánto cálculo se le aplique durante la inferencia.

En comentarios a VentureBeat, Mert Yuksekgonul, coautor del artículo y estudiante de doctorado en Stanford, ilustró esta distinción utilizando un famoso avance matemático:

“Creo que los modelos de pensamiento no serían capaces de demostrar, por ejemplo, P != NP, sin entrenamiento durante el tiempo de prueba, al igual que Andrew Wiles no sería capaz de demostrar el último teorema de Fermat sin los 7 años que pasó investigando este único problema de forma aislada y aprendiendo continuamente de sus propios fracasos”.

TTT-Uncover trata el problema de prueba no como una consulta que debe responderse, sino como un entorno que debe dominarse. A medida que el modelo intenta resolver el problema, genera diferentes tipos de datos: fracasos, éxitos parciales y errores. En lugar de descartar estos datos, TTT-Uncover los utiliza para actualizar los pesos del modelo en tiempo actual, lo que permite efectivamente que el modelo se centre en ese desafío específico en lugar de desarrollar un marco de resolución de problemas muy normal.

Un enfoque diferente al aprendizaje por refuerzo

TTT-Uncover proporciona un cambio basic en cómo se entrenan los modelos de razonamiento. En la capacitación estándar de aprendizaje por refuerzo (RL), el objetivo es una política generalista que funcione bien en promedio en muchas tareas. En TTT-Uncover, el objetivo es encontrar la mejor solución a un problema muy específico, y la política es “un medio para lograr este fin”, según los autores. Una vez que el modelo descubre el artefacto (es decir, el código optimizado, la prueba o la molécula), se puede descartar la crimson neuronal que lo produjo.

Para lograr esto, los investigadores diseñaron dos componentes específicos que diferencian TTT-Uncover del aprendizaje por refuerzo estándar:

-

Objetivo entrópico: RL estándar optimiza la recompensa promedio esperada. Si un modelo intenta un camino arriesgado y falla, el RL estándar lo castiga. TTT-Uncover cambia esto. Utiliza un “objetivo entrópico” que pondera exponencialmente los resultados de alta recompensa. Esto obliga al modelo a ignorar las respuestas promedio “seguras” y a buscar agresivamente valores atípicos “eureka”, soluciones que tienen una baja probabilidad de ser encontradas pero que ofrecen una recompensa masiva.

-

Búsqueda PUCT: El sistema introduce PUCT, un algoritmo de búsqueda de árbol inspirado en alfacero. Explora diferentes caminos de solución, creando un conjunto de datos de intentos. Luego, el modelo se entrena con este conjunto de datos en tiempo actual, aprendiendo a reconocer qué pasos parciales conducen a resultados de alta recompensa.

Fundamentalmente, este método funciona mejor en problemas con una señal de recompensa continua. El sistema necesita una forma de medir el progreso incremental, como “tiempo de ejecución en microsegundos” o “tasa de error”, en lugar de una señal binaria de “aprobación/rechazo”. Esto permite que el modelo siga la mejora gradual hacia la solución óptima.

La economía de la ‘inferencia pesada’

Para las empresas acostumbradas a pagar fracciones de centavo por llamada API, el perfil de costos de TTT-Uncover requiere un cambio de mentalidad. En sus experimentos, los investigadores informaron que una sola ejecución de descubrimiento implica aproximadamente 50 pasos de entrenamiento y miles de implementaciones, con un costo aproximado de $500 por problema.

TTT-Uncover podría ser para “activos estáticos de alto valor” en lugar de problemas triviales y recurrentes que pueden resolverse con modelos y enfoques existentes.

Considere una empresa nativa de la nube que ejecuta un canal de datos que procesa petabytes de información todas las noches. Si esa canalización se basa en una consulta SQL específica o un kernel de GPU, optimizar ese código en solo un 1 % podría ahorrar cientos de miles de dólares en costos de computación anuales. En este contexto, gastar 500 dólares para encontrar un núcleo que sea un 50% más rápido es un gasto trivial con un retorno de la inversión inmediato.

“Esto tiene más sentido para decisiones de baja frecuencia y alto impacto en las que una sola mejora vale mucho más que el costo de cómputo”, afirmó Yuksekgonul. “El enrutamiento de la cadena de suministro, el diseño de fármacos y el descubrimiento de materiales califican. En estos entornos, gastar cientos de dólares en un solo paso de descubrimiento puede amortizarse fácilmente”.

Consideraciones de implementación

Uno de los hallazgos más importantes para la adopción empresarial es que TTT-Uncover no requiere un modelo de frontera propietario. Los investigadores lograron resultados de última generación utilizando gpt-oss-120bel modelo de pesos abiertos de OpenAI. Los investigadores tienen lanzó el código para que TTT-Uncover permita a los investigadores y desarrolladores utilizarlo para sus propios modelos.

Debido a que la técnica funciona con modelos abiertos, las empresas pueden ejecutar este “bucle de descubrimiento” completamente dentro de sus propias VPC seguras o clústeres H100 locales sin enviar sus datos propietarios a servidores de terceros.

“Si una empresa ya ejecuta aprendizaje por refuerzo, no se requiere infraestructura adicional”, dijo Yuksekgonul. “TTT-Uncover utiliza la misma pila de capacitación (GPU, trabajadores de implementación, optimizadores, puntos de management)”.

Si aún no ejecutan RL, necesitarían construir esa infraestructura. Pero las empresas también pueden utilizar las soluciones existentes para reducir la complejidad del proceso. Los investigadores orquestaron estas carreras de entrenamiento utilizando el API de retoque de Considering Machines, una API que gestiona la complejidad del entrenamiento y la inferencia distribuidos.

“Herramientas como Tinker (y variantes abiertas, por ejemplo, OpenTinker) reducen el costo de instalación, y es possible que tanto los costos de mano de obra como de computación disminuyan con el tiempo”, dijo.

Casos de uso del mundo actual

Los investigadores implementaron TTT-Uncover en cuatro dominios técnicos distintos: ingeniería de sistemas, diseño de algoritmos, biología y matemáticas. En casi todos los casos, el método marcó un nuevo hito.

En un experimento, el modelo optimizó los núcleos de GPU para la multiplicación de matrices (incluido el núcleo “TriMul” utilizado en AlfaFold), logrando velocidades de ejecución hasta 2 veces más rápidas que las de última generación y superando en la clasificación a los mejores núcleos escritos por humanos.

En escenarios de programación competitivos (EnCoder), resolvió problemas heurísticos complejos (por ejemplo, optimizar las restricciones geométricas para las redes de pesca) mejor que los mejores expertos humanos y las líneas de base de IA anteriores.

Para la empresa, la transición de estos puntos de referencia académicos al valor empresarial depende de una restricción específica: la existencia de una señal escalar verificable. A diferencia de un chatbot que genera texto, TTT-Uncover necesita una métrica concreta (por ejemplo, tiempo de ejecución, tasa de error o margen de beneficio) para optimizar.

Yuksekgonul dijo que este requisito traza una línea clara entre dónde se debe y no se debe utilizar esta tecnología. “Por el momento, el requisito clave es una señal escalar confiable de progreso (coste, error, propiedades moleculares) contra la cual el sistema pueda optimizar”, dijo.

Esto dirige la adopción empresarial hacia desafíos “difíciles” de ingeniería y operaciones, como la logística, la cadena de suministro y la gestión de recursos, donde problemas como el enrutamiento de flotas o la programación de tripulaciones a menudo dependen de heurísticas estáticas. TTT-Uncover puede tratarlos como entornos de optimización, dedicando horas a encontrar una estructura de ruta que reduzca un 5% los costos diarios de flamable.

El requisito de verificadores claros descarta tareas cualitativas como “escribir una mejor estrategia de advertising and marketing”, donde la verificación es subjetiva y propensa a ruido.

“Los problemas difíciles de verificar siguen siendo una cuestión abierta”, dijo Yuksekgonul.

Con la tecnología precise, el mejor camino a seguir es intentar diseñar verificadores, pero “hacer que esos verificadores sean robustos y difíciles de manipular es un desafío, y todavía no tenemos una buena solución”, añadió.

De la inferencia a la invención

La implicación más amplia es que es posible que las pilas de IA empresarial deban evolucionar para respaldar este tipo de aprendizaje por problema.

“Los sistemas construidos alrededor de un modelo congelado necesitarán soportar la adaptación por problema (o por dominio), y las empresas necesitarán mejores especificaciones de problemas y señales de retroalimentación interna para que el aprendizaje en el momento de la prueba sea efectivo”, dijo Yuksekgonul. “Si la capacitación se realiza dentro de una VPC privada, el circuito de capacitación también se puede integrar con una mayor parte del entorno interno de la empresa, no solo con un laboratorio central”.

Para la empresa, el valor radica en identificar “problemas de millones de dólares”, desafíos de optimización en los que existe una métrica verificable, pero el progreso humano se ha estancado. Estos son los candidatos al TTT-Uncover. Al aceptar una mayor latencia y costos para consultas específicas, las empresas pueden convertir su computación de inferencia en un laboratorio de I+D automatizado, descubriendo soluciones que antes estaban fuera del alcance tanto de los humanos como de los modelos congelados de IA.