Siga ZDNET: Agréganos como fuente preferida en Google.

Conclusiones clave de ZDNET

- La IA se ejecuta en Linux. Período. No hay sustitutos.

- Canonical y Purple Hat están creando distribuciones de Linux específicas para Nvidia Vera Rubin.

- El kernel de Linux se está adaptando a cargas de trabajo de IA y ML.

La IA moderna comenzó con el código abierto y se ejecutaba en Linux. Hoy en día, Linux no sólo es importante para la inteligencia synthetic; es la base sobre la que se ejecuta toda la pila de IA moderna de hoy. Desde grupos de entrenamiento a hiperescala hasta cuadros de inferencia perimetrales, todo es Linux de arriba a abajo.

También: Probé una distribución de Linux que promete inteligencia synthetic integrada y gratuita, y las cosas se pusieron raras

Los trucos de magia de la IA son en realidad el resultado agregado de una infraestructura muy prosaica: supercomputadoras, granjas de GPU y clústeres de nube que casi todos ejecutan alguna versión de Linux. Los marcos centrales de aprendizaje automático (TensorFlow, PyTorch, scikit-learn y amigos) fueron todos desarrollado y ajustado primero en Linux. Las herramientas utilizadas en estas herramientas, desde Jupyter y Anaconda hasta Docker y Kubernetes, están igualmente optimizadas para Linux.

Por qué los trabajos de TI vivirán y morirán en Linux

¿Por qué? Porque es en Linux donde los investigadores e ingenieros de producción realmente implementan la IA. Los futuros trabajos de TI vivirán y morirán en Linux.

Verá, la IA se ejecuta en Linux porque es el entorno más versatile, potente y escalable para las cargas de trabajo distribuidas y con mucha GPU que requiere la IA moderna. Además, todo el ecosistema de herramientas y nube se ha estandarizado en Linux.

Sí, todas las plataformas de IA, ya sea OpenAI, Copilot, Perplexity, Anthropic o su chatbot de IA favorito, están construidas en Linux, además de controladores, bibliotecas y orquestación, todos unidos de diferentes maneras. Los bits propietarios pueden acaparar la marca, pero sin Linux, no están en ninguna parte.

Eso se traduce en más trabajos de Linux.

Como la Fundación Linux Informe sobre el talento tecnológico sobre el estado de la tecnología 2025 Como se señaló, la IA está impulsando un aumento neto de los empleos tecnológicos, particularmente los empleos de Linux. Lo que esto parece se scale back a “IA [is] “Remodelar roles en lugar de eliminarlos”, según el informe, “lo que lleva a cambios en la demanda de habilidades y nuevas oportunidades para el crecimiento de la fuerza laboral”.

Además de aumentar los puestos de trabajo de administración de redes y sistemas Linux, el sitio Carreras en Linux ve “una tendencia que está surgiendo rápidamente y que implica profesionales que combinan experiencia en Linux con inteligencia artificial y operaciones de aprendizaje automático”. Estos nuevos trabajos de AI/Linux incluyen Especialista en Operaciones de AI, Ingeniero de MLOps, Ingeniero de ML e Ingeniero de DevOps/AI.

Por supuesto, los distribuidores de Linux saben todo esto, razón por la cual, cuando se lanzan nuevas distribuciones de Linux, sus creadores enfatizan las características de inteligencia synthetic.

Por ejemplo, Canónico y sombrero rojo están compitiendo para plantar sus banderas de Linux en la nueva plataforma de supercomputadora Vera Rubin AI de Nvidia. La carrera ha comenzado para ver quién será el propietario de la capa del sistema operativo de las “fábricas de IA a gigaescala”.

Por su parte, Purple Hat está introduciendo Red Hat Enterprise Linux (RHEL) para NVIDIA. Esta edición seleccionada de RHEL está optimizada específicamente para la plataforma Rubin de Nvidia, incluida la Sistemas de báscula en rack Vera Rubin NVL72.

También: Cómo la IA y Rust están reescribiendo la programación de Linux y Home windows

La compañía cube que esta variante se enviará con soporte desde el día 0 para la CPU Vera, las GPU Rubin y la pila CUDA X de Nvidia, con controladores y kits de herramientas OpenRM validados entregados directamente a través de los repositorios de Purple Hat.

El kernel de Linux y la IA

Canonical también está implementando soporte oficial de Ubuntu para la plataforma Nvidia Rubin, también apuntando a Vera Rubin NVL72. La compañía con sede en Londres está basando su historia en hacer de la CPU Vera personalizada basada en Arm un “ciudadano de primera clase”, con paridad x86 en su próximo Lanzamiento de Ubuntu 26.04.

Entonces, a diferencia de Purple Hat, que tiene un RHEL solo para los procesadores de Nvidia, el nuevo Ubuntu será appropriate con Nvidia. Esta versión también incorporará funciones como Virtualización anidada y Partición y monitoreo de memoria ARM (MPAM) para particionar mejor el ancho de banda de la memoria y el caché para cargas de trabajo de IA de múltiples inquilinos.

También: Incluso Linus Torvalds ahora codifica vibraciones

Lo que ejecuta todo esto es un kernel de Linux que ha sido modificado constantemente para mantenerse al día con el apetito voraz de la IA por la aceleración de {hardware}. Los núcleos modernos hacen malabarismos con la GPU y controladores de acelerador especializados, una gestión de memoria sofisticada para mover tensores rápidamente y programadores ajustados para trabajos por lotes masivamente paralelos.

En resumen, el núcleo ha sido reconfigurado durante la última década para convertirse en un sistema operativo para aceleradores de {hardware} de IA.

Memoria: poner datos donde están las GPU

Específicamente, uno de los facilitadores más importantes ha sido Gestión de memoria heterogénea. Esto permite que la memoria del dispositivo, como la Unidad de procesamiento de gráficos/Memoria de acceso aleatorio de vídeo (GPU VRAM), se integre en el subsistema de memoria digital de Linux.

Eso, combinado con el búfer de acceso directo a memoria (DMA-BUF) y Acceso a memoria no uniforme (NUMA) La optimización permite que los tiempos de ejecución de IA mantengan los tensores cerca del acelerador y reduzcan la copia de datos, lo que tiende a ralentizar el rendimiento.

También: Así es como finalmente resolví un complicado problema de Linux con esta aplicación de terminal de IA

Los kernels recientes también tratan las combinaciones avanzadas de CPU-GPU, como los nodos CPU/GPU de estilo NUMA estrechamente acoplados, como ciudadanos de primera clase. Con esto, la memoria se puede migrar entre la RAM conectada a la CPU y la memoria de la GPU de gran ancho de banda según sea necesario.

Esto, como explicó Nvidia, “permite que la CPU y la GPU compartan una única tabla de páginas por proceso, permitiendo que todos los subprocesos de CPU y GPU accedan a toda la memoria asignada por el sistema“.

Aceleradores: un subsistema actual, no un complemento

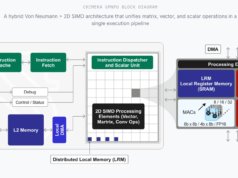

Linux ahora tiene un subsistema de aceleradores de computación dedicado que está diseñado para exponer GPU, unidades de procesamiento tensorial (TPU) y circuitos integrados personalizados específicos de aplicaciones (ASIC) de IA a sus programas de IA y aprendizaje automático (ML).

Además de eso, el soporte de GPU ha madurado desde gráficos primero hasta computación pesada, a través del Direct Rendering Supervisor (DRM), pilas abiertas como ROCm y OpenCL, y los controladores Compute Unified Gadget Structure (CUDA) de Nvidia.

También: La IA ya es parte de las tuberías de Linux, les guste o no a los desarrolladores

El trabajo del kernel se ha ampliado para cubrir aceleradores de IA más nuevos, como Habana Gaudi de Intel, Edge TPU de Google y placas FPGA/ASIC, con controladores y abstracciones de bus. Esto permite que programas de inteligencia synthetic como PyTorch o TensorFlow los vean y utilicen como un dispositivo más. Por lo tanto, cualquiera que hoy fabrique nuevo silicio de IA supone con razón que Linux se ejecutará en él.

Programación: alimentar a los aceleradores hambrientos

El programador predeterminado de Linux, el Primero la fecha límite virtual elegible más temprana (EEVDF)el programador en tiempo actual y el equilibrio NUMA se han ajustado para permitir que las cargas de trabajo de IA fijen las CPU, aíslen a los vecinos ruidosos y alimenten los aceleradores sin fluctuaciones. Seguir trabajando aumentar la frecuencia predeterminada del temporizador del kernel de 250 Hz a 1000 Hz ya está mostrando aumentos mensurables en la aceleración del modelo de lenguaje grande (LLM) con un costo de energía insignificante.

También: Encontré 7 aplicaciones de Linux esenciales para estudiantes, incluida una IA native

Si bien no es una configuración predeterminada de Linux, algunas distribuciones, como Kernels de baja latencia de Ubuntuahora viene con esto como configuración estándar.

Rutas directas: eliminar al intermediario de la CPU

Los kernels modernos permiten que las GPU accedan a la memoria, al almacenamiento e incluso a dispositivos pares directamente, utilizando tecnologías como Nvidia. GPUDirect y DMA de igual a igual. Combinado con Enlace Compute Express (CXL)) y el manejo mejorado de la Unidad de administración de memoria de entrada/salida (IOMMU), permite a los aceleradores omitir la CPU al mover datos. Esto elimina los cuellos de botella que anteriormente paralizaban las ejecuciones de capacitación de ML. Esta tubería invisible es la razón por la que los clústeres de IA pueden escalar sin colapsar bajo su propia E/S.

También: Mis dos aplicaciones de IA favoritas en Linux y cómo las uso para hacer más cosas

Lo que todo esto significa es que, cuando los ejecutivos hablan de “estrategia de IA”, lo que no están diciendo es que la poco glamorosa realidad es que la estrategia de IA depende de la gestión de Linux a escala. Se trata de parchear kernels, reforzar contenedores y proteger cargas de trabajo opacas. La IA puede aparecer en los titulares, pero Linux sigue siendo el sistema operativo que hace el trabajo actual.