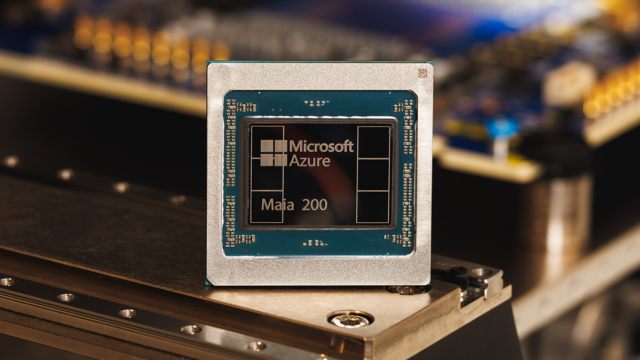

Microsoft ha anunciado el lanzamiento de su último chip, el Maia 200, que la compañía describe como un caballo de batalla de silicio diseñado para escalar la inferencia de IA.

El 200, que sigue la línea de la compañía Maia 100 lanzado en 2023ha sido técnicamente equipado para ejecutar potentes modelos de IA a velocidades más rápidas y con mayor eficiencia, afirmó la compañía. Maia viene equipado con más de 100 mil millones de transistores, lo que ofrece más de 10 petaflops con precisión de 4 bits y aproximadamente 5 petaflops de rendimiento de 8 bits, un aumento sustancial con respecto a su predecesor.

La inferencia se refiere al proceso informático de ejecutar un modelo, en contraste con el proceso informático necesario para entrenarlo. A medida que las empresas de IA maduran, los costos de inferencia se han convertido en una parte cada vez más importante de sus costos operativos generales, lo que ha generado un renovado interés en formas de optimizar el proceso.

Microsoft espera que Maia 200 pueda ser parte de esa optimización, haciendo que las empresas de IA funcionen con menos interrupciones y menor uso de energía. “En términos prácticos, un nodo Maia 200 puede ejecutar sin esfuerzo los modelos más grandes de hoy, con mucho espacio para modelos aún más grandes en el futuro”, dijo la compañía.

El nuevo chip de Microsoft también es parte de una tendencia creciente de gigantes tecnológicos que recurren a chips de diseño propio como una forma de disminuir su dependencia de NVIDIA, cuyo GPU de última generación se han vuelto cada vez más fundamentales para el éxito de las empresas de IA. Google, por ejemplo, tiene su TPU, las unidades de procesamiento de tensores, que no se venden como chips sino como potencia informática accesible a través de su nube. Luego está Amazon Trainium, el chip acelerador de IA del gigante del comercio electrónico, que acaba de lanzar su última versiónel Trainium3, en diciembre. En cada caso, las TPU se pueden utilizar para descargar parte del cómputo que de otro modo se asignaría a las GPU NVIDIA, lo que scale back el costo normal del {hardware}.

Con Maia, Microsoft se está posicionando para competir con esas alternativas. En su comunicado de prensa del lunes, la compañía señaló que Maia ofrece 3 veces el rendimiento FP4 de los chips Amazon Trainium de tercera generación y un rendimiento FP8 superior al TPU de séptima generación de Google.

Microsoft cube que Maia ya está trabajando arduamente para impulsar los modelos de inteligencia synthetic de la compañía desde su equipo de Superinteligencia. También ha estado apoyando las operaciones de Copilot, su chatbot. Hasta el lunes, la compañía dijo que había invitado a una variedad de partes, incluidos desarrolladores, académicos y laboratorios de inteligencia synthetic de vanguardia, a utilizar su equipment de desarrollo de software program Maia 200 en sus cargas de trabajo.

Evento tecnológico

san francisco

|

13-15 de octubre de 2026