Las dos grandes historias de la IA en 2026 hasta ahora han sido el increíble aumento en el uso y el elogio del Claude Code de Anthropic y un programa related. gran impulso en la adopción por parte de los usuarios de la familia de modelos de IA Gemini 3 de Google lanzada a fines del año pasado; el último de los cuales incluye Nano Banana Professional (también conocido como Gemini 3 Professional Picture), un modelo de generación de imágenes potente, rápido y versatile que representa infografías complejas con mucho texto de manera rápida y precisa, lo que lo convierte en una excelente opción para el uso empresarial (piense: materials colateral, capacitaciones, incorporación, papelería, and so forth.).

Pero, por supuesto, ambas son ofertas patentadas. Y, sin embargo, los rivales del código abierto no se han quedado atrás.

Esta semana, obtuvimos una nueva alternativa de código abierto a Nano Banana Professional en la categoría de generadores de imágenes precisos con mucho texto: Imagen GLMun nuevo modelo de código abierto de 16 mil millones de parámetros de rStartup china recientemente pública Z.ai.

Al abandonar la arquitectura de “difusión pura” estándar de la industria que impulsa la mayoría de los principales modelos de generación de imágenes en favor de un diseño híbrido autorregresivo (AR) + difusión, GLM-Picture ha logrado lo que antes se pensaba que period el dominio de los modelos cerrados y propietarios: rendimiento de última generación en la generación de imágenes con mucho texto y densa información, como infografías, diapositivas y diagramas técnicos.

Incluso supera al Nano Banana Professional de Google en el compartido por z.ai, aunque en la práctica, mi uso rápido descubrió que es mucho menos preciso a la hora de seguir instrucciones y representar texto (y otros usuarios parecen estar de acuerdo).

Pero para las empresas que buscan alternativas rentables, personalizables y con licencia amigable a los modelos patentados de IA, GLM-Picture de z.ai puede ser “lo suficientemente bueno” o algo más para asumir el trabajo de un generador de imágenes primario, dependiendo de sus casos de uso, necesidades y requisitos específicos.

El punto de referencia: derrocar al gigante propietario

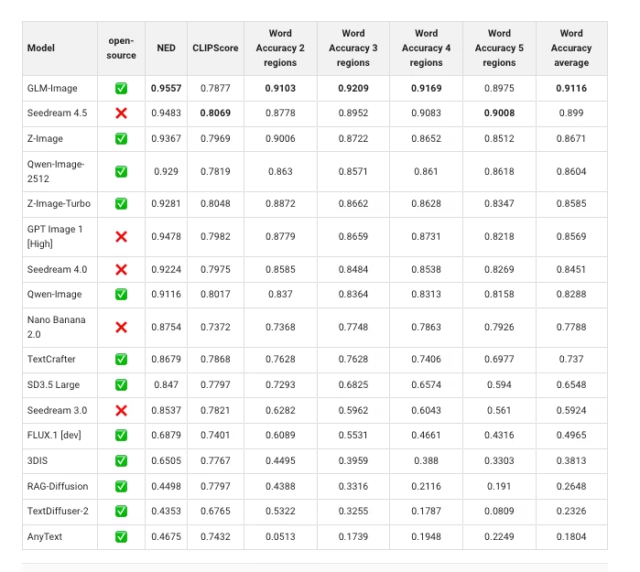

El argumento más convincente a favor de GLM-Picture no es su estética, sino su precisión. En el Prueba comparativa CVTG-2k (generación de texto visual complejo), que evalúa la capacidad de un modelo para representar texto preciso en múltiples regiones de una imagen, GLM-Picture obtuvo un promedio de precisión de palabras de 0,9116.

Para poner ese número en perspectiva, Nano Banana 2.0, también conocido como Professional, citado a menudo como punto de referencia para la confiabilidad empresarial, obtuvo una puntuación de 0,7788. Esta no es una ganancia marginal; es un salto generacional en el management semántico.

Si bien Nano Banana Professional conserva una ligera ventaja en la generación de texto largo en inglés de flujo único (0,9808 frente a 0,9524 de GLM-Picture), falla significativamente cuando aumenta la complejidad.

A medida que crece el número de regiones de texto, la precisión de Nano Banana se mantiene en los 70, mientras que GLM-Picture mantiene >90% de precisión incluso con múltiples elementos de texto distintos.

Para los casos de uso empresarial, donde una diapositiva de advertising necesita un título, tres viñetas y un título simultáneamente, esta confiabilidad es la diferencia entre un activo listo para producción y una alucinación.

Desafortunadamente, mi propio uso de un inferencia de demostración de GLM-Image en Hugging Face resultó ser menos fiable de lo que podrían sugerir los puntos de referencia.

Mi solicitud de generar una “infografía que etiquete todas las constelaciones principales visibles desde el hemisferio norte de EE. UU. en este momento el 14 de enero de 2026 y coloque imágenes descoloridas de sus homónimos detrás de los diagramas de líneas de conexión de estrellas” no resultó en lo que pedí, sino que cumplió tal vez el 20% o menos del contenido especificado.

Pero Nano Banana Professional de Google lo manejó como un campeón, como verá a continuación:

Por supuesto, una gran parte de esto se debe sin duda al hecho de que Nano Banana Professional está integrado con la búsqueda de Google, por lo que puede buscar información en la net en respuesta a mi solicitud, mientras que GLM-Picture no lo está y, por lo tanto, probablemente requiera instrucciones mucho más específicas sobre el texto actual y otro contenido que la imagen debe contener.

Pero aún así, una vez que esté acostumbrado a poder escribir algunas instrucciones simples y obtener una imagen completamente investigada y bien poblada a través de este último, es difícil imaginar implementar una alternativa deficiente a menos que tenga requisitos muy específicos en cuanto a costo, residencia de datos y seguridad, o que las necesidades de personalización de su organización sean tan grandes.

Además, Nano Banana Professional aún superó a GLM-Picture en términos de estética pura — utilizando el punto de referencia OneIG, Nano Banana 2.0 está en 0,578 frente a GLM-Picture en 0,528 Y, de hecho, como indica el arte del encabezado superior de este artículo, GLM-Picture no siempre genera una imagen tan nítida, finamente detallada y agradable como el generador de Google.

El cambio arquitectónico: por qué es importante lo “híbrido”

¿Por qué GLM-Picture tiene éxito donde fracasan los modelos de difusión pura? La respuesta está en la decisión de Z.ai de tratar la generación de imágenes primero como un problema de razonamiento y después como un problema de pintura.

Los modelos de difusión latente estándar (como Steady Diffusion o Flux) intentan manejar la composición world y la textura de grano fino simultáneamente.

Esto a menudo conduce a una “deriva semántica”, donde el modelo olvida instrucciones específicas (como “colocar el texto en la parte superior izquierda”) mientras se concentra en hacer que los píxeles parezcan realistas.

GLM-Picture desacopla estos objetivos en dos “cerebros” especializados que suman un whole de 16 mil millones de parámetros:

-

El Generador Auto-Regresivo (El “Arquitecto”): Inicializado a partir del modelo de lenguaje GLM-4-9B de Z.ai, este módulo de 9 mil millones de parámetros procesa el mensaje de manera lógica. No genera píxeles; en su lugar, genera “tokens visuales”, específicamente tokens VQ semánticos. Estos tokens actúan como un plano comprimido de la imagen, fijando el diseño, la ubicación del texto y las relaciones de los objetos antes de que se dibuje un solo píxel. Esto aprovecha el poder de razonamiento de un LLM, permitiendo que el modelo “comprenda” instrucciones complejas (por ejemplo, “un tutorial de cuatro paneles”) de una manera que los predictores de ruido de difusión no pueden.

-

El Decodificador de Difusión (El “Pintor”): Una vez que el módulo AR bloquea el diseño, un decodificador de transformador de difusión (DiT) de 7 mil millones de parámetros toma el management. Basado en la arquitectura CogView4, este módulo completa los detalles de alta frecuencia: textura, iluminación y estilo.

Al separar el “qué” (AR) del “cómo” (Difusión), GLM-Picture resuelve el problema del “conocimiento denso”. El módulo AR garantiza que el texto esté escrito correctamente y colocado con precisión, mientras que el módulo Difusión garantiza que el resultado closing parezca fotorrealista.

Entrenando al híbrido: una evolución de varias etapas

El ingrediente secreto del rendimiento de GLM-Picture no es sólo la arquitectura; Es un plan de estudios de capacitación altamente específico y de múltiples etapas que obliga al modelo a aprender la estructura antes que los detalles.

El proceso de entrenamiento comenzó congelando la capa de incrustación de palabras de texto del modelo GLM-4 unique mientras se entrenaba una nueva capa de “incrustación de palabras de visión” y un cabezal LM de visión especializado.

Esto permitió que el modelo proyectara tokens visuales en el mismo espacio semántico que el texto, enseñando efectivamente al LLM a “hablar” en imágenes. Fundamentalmente, Z.ai implementó MRoPE (incrustación posicional rotativa multidimensional) para manejar el complejo intercalado de texto e imágenes requerido para la generación de modos mixtos.

Luego, el modelo fue sometido a una estrategia de resolución progresiva:

-

Etapa 1 (256 px): El modelo se entrenó en secuencias de 256 tokens de baja resolución utilizando un orden de escaneo de trama easy.

-

Etapa 2 (512 px – 1024 px): A medida que la resolución aumentó a una etapa mixta (512 px a 1024 px), el equipo observó una caída en la controlabilidad. Para solucionar este problema, abandonaron el escaneo easy por una estrategia de generación progresiva.

En esta etapa avanzada, el modelo genera primero aproximadamente 256 “tokens de diseño” a partir de una versión reducida de la imagen de destino.

Estos tokens actúan como un ancla estructural. Al aumentar el peso del entrenamiento en estos tokens preliminares, el equipo obligó al modelo a priorizar el diseño world (dónde están las cosas) antes de generar los detalles de alta resolución. Esta es la razón por la que GLM-Picture sobresale en carteles y diagramas: primero “dibuja” el diseño, asegurando que la composición sea matemáticamente sólida antes de representar los píxeles.

Análisis de licencias: una victoria permisiva, aunque ligeramente ambigua, para las empresas

Para los CTO empresariales y los equipos legales, la estructura de licencias de GLM-Picture es una ventaja competitiva significativa sobre las API propietarias, aunque conlleva una pequeña advertencia con respecto a la documentación.

La ambigüedad: hay una ligera discrepancia en los materiales de publicación. El repositorio Hugging Face del modelo explícitamente etiqueta los pesos con la licencia MIT.

Sin embargo, el repositorio y la documentación de GitHub que lo acompañan sonHaga referencia a la licencia Apache 2.0.

Por qué esto sigue siendo una buena noticia: a pesar de la discrepancia, ambas licencias son el “estándar de oro” para el código abierto favorable a las empresas.

-

Viabilidad Comercial: Tanto el MIT como Apache 2.0 permiten el uso, modificación y distribución comercial sin restricciones. A diferencia de las licencias de “carril abierto” comunes en otros modelos de imágenes (que a menudo restringen casos de uso específicos) o las licencias “solo para investigación” (como las primeras versiones de LLaMA), GLM-Picture está efectivamente “abierto para los negocios” de inmediato.

-

La ventaja de Apache (si corresponde): Si el código pertenece a Apache 2.0, esto resulta especialmente beneficioso para las grandes organizaciones. Apache 2.0 incluye una cláusula explícita de concesión de patente, lo que significa que al contribuir o utilizar el software program, los contribuyentes otorgan una licencia de patente a los usuarios. Esto cut back el riesgo de futuros litigios sobre patentes, una preocupación importante para las empresas que crean productos sobre bases de código de fuente abierta.

-

Sin “infección”: Ninguna licencia es “copyleft” (como GPL). Puede integrar GLM-Picture en un flujo de trabajo o producto propietario sin verse obligado a abrir su propia propiedad intelectual.

Para los desarrolladores, la recomendación es easy: trate los pesos como MIT (según el repositorio que los aloja) y el código de inferencia como Apache 2.0. Ambos caminos despejan el camino para el alojamiento interno, el ajuste de datos confidenciales y la creación de productos comerciales sin un contrato de bloqueo de proveedor.

El “por qué ahora” para las operaciones empresariales

Para quienes toman decisiones empresariales, GLM-Picture llega a un punto de inflexión crítico. Las empresas están yendo más allá del uso de IA generativa para encabezados de blogs abstractos y hacia territorio funcional: localización multilingüe de anuncios, generación automatizada de maquetas de interfaz de usuario y materiales educativos dinámicos.

En estos flujos de trabajo, una tasa de error del 5% en la representación de texto es un obstáculo. Si un modelo genera una hermosa diapositiva pero escribe mal el nombre del producto, el activo es inútil. Los puntos de referencia sugieren que GLM-Picture es el primer modelo de código abierto que cruza el umbral de confiabilidad para estas complejas tareas.

Además, las licencias permisivas cambian fundamentalmente la economía del despliegue. Mientras que Nano Banana Professional bloquea a las empresas en una estructura de costos API por llamada o contratos de nube restrictivos, GLM-Picture puede autohospedarse, ajustarse a los activos de marca patentados e integrarse en canales seguros y aislados sin problemas de fuga de datos.

El truco: requisitos informáticos pesados

La contrapartida de esta capacidad de razonamiento es la intensidad de cálculo. La arquitectura del modelo twin es pesada. Generar una única imagen de 2048×2048 requiere aproximadamente 252 segundos en una GPU H100. Esto es significativamente más lento que los modelos de difusión más pequeños y altamente optimizados.

Sin embargo, para activos de alto valor (donde la alternativa es que un diseñador humano pase horas en Photoshop) esta latencia es aceptable.

Z.ai también ofrece una API administrada a $0.015 por imagenproporcionando un puente para los equipos que desean probar las capacidades sin invertir en clústeres H100 de inmediato.

GLM-Picture es una señal de que la comunidad de código abierto ya no se limita a seguir rápidamente laboratorios propietarios; en sectores verticales específicos de alto valor, como la generación densa de conocimiento, ahora están marcando el ritmo. Para las empresas, el mensaje es claro: si su cuello de botella operativo es la confiabilidad del contenido visible complejo, la solución ya no es necesariamente un producto cerrado de Google; podría ser un modelo de código abierto que usted mismo puede ejecutar.