Todo el mundo en la industria habla de un auge en la demanda de IA y la consiguiente escasez de suministro de memoria. En CES 2026 en Las Vegas, Nevada, también estuvo en el centro de los últimos lanzamientos importantes de productos de Nvidia.

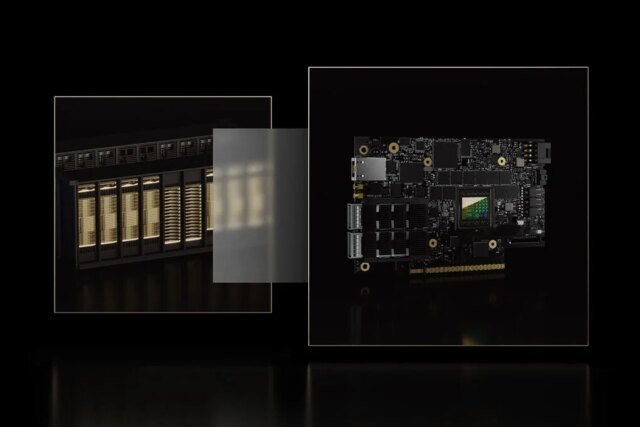

El lunes, la compañía lanzó oficialmente la plataforma Rubin, compuesta por seis chips que se combinan en una supercomputadora de inteligencia synthetic, que según los funcionarios de la compañía es más eficiente que los modelos Blackwell y cuenta con aumentos en el ancho de banda de cómputo y memoria.

“Rubin llega exactamente en el momento adecuado, ya que la demanda de computación de IA tanto para entrenamiento como para inferencia se está disparando”, dijo el CEO de Nvidia, Jensen Huang, en un comunicado de prensa.

Los productos basados en Rubin estarán disponibles a través de los socios de Nvidia en la segunda mitad de 2026, dijeron ejecutivos de la compañía, nombrando a AWS, Anthropic, Google, Meta, Microsoft, OpenAI, Oracle y xAI entre las empresas que se espera que adopten Rubin.

“Las ganancias de eficiencia en la plataforma NVIDIA Rubin representan el tipo de progreso en la infraestructura que permite una memoria más larga, un mejor razonamiento y resultados más confiables”, dijo el CEO de Anthropic, Dario Amodei, en el comunicado de prensa.

Las GPU se han convertido en un bien caro y escaso a medida que los proyectos de centros de datos en rápida expansión agotan el suministro international de chips de memoria. Según un reciente informe de Tom’s {Hardware}, los gigantescos proyectos de centros de datos requirieron aproximadamente el 40% del costo international DRACMA salida de chips. La escasez ha llegado a tal punto que está provocando aumentos de precios en la electrónica de consumo y se rumorea que también afectará los precios de las GPU. Según un informe de la agencia de noticias de Corea del Sur. noticiasse espera que el fabricante de chips AMD aumente los precios de algunas de sus ofertas de GPU a finales de este mes, y Nvidia supuestamente hará lo mismo en febrero.

El objetivo de Nvidia ha sido evadir este cuello de botella de chips. El mes pasado, el gigante tecnológico realizó la compra más grande de su historia con Groqun fabricante de chips que se especializa en inferencia.

Ahora, con un producto que promete altos niveles de inferencia y la capacidad de entrenar modelos complejos con menos chips a un costo menor, la compañía podría esperar aliviar algunas de esas preocupaciones generadas por la escasez en la industria. Los ejecutivos de la compañía compartieron que Rubin ofrece una reducción de hasta diez veces en los costos de los tokens de inferencia y una reducción de cuatro veces en la cantidad de GPU utilizadas para entrenar modelos que se basan en una arquitectura de inteligencia synthetic llamada mezcla de expertos (MoE), como DeepSeek.

Además, la compañía también está presentando una nueva clase de infraestructura de almacenamiento nativa de IA diseñada específicamente para la inferencia, llamada Inference Context Reminiscence Storage Platform.

La IA agente, la novedad más candente en el mundo de la tecnología durante el último año, ha otorgado una importancia cada vez mayor a la memoria de la IA. En lugar de simplemente responder a preguntas únicas, ahora se espera que los sistemas de IA recuerden mucha más información sobre interacciones anteriores para llevar a cabo algunas tareas de forma autónoma, lo que significa que hay más datos que gestionar durante la etapa de inferencia.

La nueva plataforma pretende resolver esto añadiendo un nuevo nivel de memoria para inferencia, para almacenar algunos datos de contexto y ampliar la capacidad de memoria de la GPU.

“El cuello de botella está pasando de la computación a la gestión del contexto”, dijo Dion Harris, director senior de soluciones de infraestructura de hiperescala de HPC e IA de Nvidia. “Para escalar, el almacenamiento ya no puede ser una ocurrencia tardía”.

“A medida que la inferencia escala a escala giga, el contexto se convierte en un tipo de datos de primera clase, y la nueva plataforma de almacenamiento de memoria contextual de inferencia de Nvidia está en una posición excellent para admitirlo”, afirmó Harris.

El tiempo dirá si la eficiencia puede abordar con éxito algunos de los cuellos de botella provocados por la intensa demanda de chips. Pero incluso si se resuelve el problema de la memoria, la industria de la IA seguirá enfrentándose a otros obstáculos en su crecimiento sin precedentes, sobre todo a través de la inmensa cepa que los centros de datos ponen en la pink eléctrica de Estados Unidos.