Investigadores de Nvidia han desarrollado una técnica que puede reducir hasta ocho veces los costos de memoria del razonamiento de modelos de lenguaje grandes. Su técnica, llamada dispersión de la memoria dinámica (DMS), comprime la caché de valores clave (KV), la memoria temporal que los LLM generan y almacenan a medida que procesan solicitudes y razonan problemas y documentos.

Si bien los investigadores han propuesto varios métodos para comprimir este caché antes, la mayoría tiene dificultades para hacerlo sin degradar la inteligencia del modelo. El enfoque de Nvidia logra descartar gran parte del caché mientras mantiene (y en algunos casos mejora) las capacidades de razonamiento del modelo.

Los experimentos muestran que DMS permite a los LLM “pensar” durante más tiempo y explorar más soluciones sin la penalización ordinary en velocidad o costos de memoria.

El cuello de botella del razonamiento

Los LLM mejoran su desempeño en tareas complejas generando “cadena de pensamiento” tokens, esencialmente escribiendo sus pasos de razonamiento antes de llegar a una respuesta last. Las técnicas de escalado de tiempo de inferencia aprovechan esto al darle al modelo un presupuesto mayor para generar estos tokens de pensamiento o para explorar múltiples caminos potenciales de razonamiento en paralelo.

Sin embargo, este razonamiento mejorado conlleva un coste computacional significativo. A medida que el modelo genera más tokens, construye un caché KV.

Para aplicaciones del mundo actual, la caché KV es un cuello de botella importante. A medida que crece la cadena de razonamiento, la caché crece linealmente, consumiendo grandes cantidades de memoria en las GPU. Esto obliga al {hardware} a dedicar más tiempo a leer datos de la memoria que a computarlos, lo que ralentiza la generación y aumenta la latencia. También limita la cantidad de usuarios que un sistema puede atender simultáneamente, ya que quedarse sin VRAM hace que el sistema falle o se ralentice.

Los investigadores de Nvidia plantean esto no sólo como un obstáculo técnico, sino también como un obstáculo económico elementary para la empresa.

“La pregunta no es sólo la cantidad de {hardware}; se trata de si su infraestructura está procesando 100 subprocesos de razonamiento u 800 subprocesos por el mismo costo”, dijo a VentureBeat Piotr Nawrot, ingeniero senior de aprendizaje profundo de Nvidia.

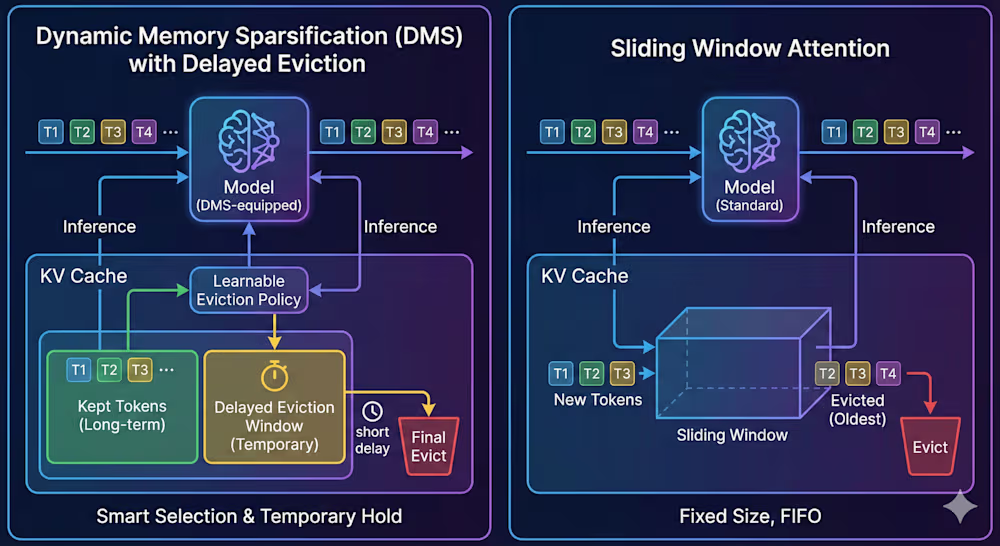

Los intentos anteriores de resolver este problema se centraron en enfoques basados en heurísticas. Estos métodos utilizan reglas rígidas, como una “ventana deslizante” que solo almacena en caché los tokens más recientes y elimina el resto. Si bien esto cut back el uso de memoria, a menudo obliga al modelo a descartar información crítica necesaria para resolver el problema, lo que degrada la precisión de la salida.

“Los métodos de desalojo estándar intentan seleccionar tokens viejos y no utilizados para el desalojo utilizando heurísticas”, dijeron los investigadores. “Simplifican el problema, con la esperanza de que si se aproximan a la mecánica interna del modelo, la respuesta seguirá siendo correcta”.

Otras soluciones utilizan paginación para descargar las partes no utilizadas de la caché KV a una memoria más lenta, pero el constante intercambio de datos introduce una sobrecarga de latencia que hace que las aplicaciones en tiempo actual sean lentas.

Dispersión de la memoria dinámica

DMS adopta un enfoque diferente al “adaptar” los LLM existentes para que administren de manera inteligente su propia memoria. En lugar de aplicar una regla fija sobre qué eliminar, DMS entrena el modelo para identificar qué tokens son esenciales para el razonamiento futuro y cuáles son desechables.

“No sólo adivina la importancia; aprende una política que preserva explícitamente la distribución de producción last del modelo”, dijo Nawrot.

El proceso transforma un LLM estándar previamente entrenado, como Llama 3 o Qwen 3, en un modelo autocomprimido. Fundamentalmente, esto no requiere entrenar el modelo desde cero, lo que sería prohibitivamente costoso. En cambio, DMS reutiliza las neuronas existentes dentro de las capas de atención del modelo para generar una señal de “mantener” o “desalojar” para cada token.

Para los equipos preocupados por la complejidad de la modernización, los investigadores observaron que el proceso está diseñado para ser liviano. “Para mejorar la eficiencia de este proceso, los pesos del modelo se pueden congelar, lo que hace que el proceso sea related a la Adaptación de bajo rango (LoRA)”, dijo Nawrot. Esto significa que un modelo empresarial estándar como el Qwen3-8B “puede adaptarse con DMS en cuestión de horas en un solo DGX H100”.

Una de las partes importantes del DMS es un mecanismo llamado “desalojo retrasado”. En la dispersión estándar, si un token se considera sin importancia, se elimina inmediatamente. Esto es arriesgado porque el modelo podría necesitar una fracción de segundo para integrar el contexto de ese token en su estado precise.

DMS mitiga esto marcando un token para desalojo pero manteniéndolo accesible durante un breve período de tiempo (por ejemplo, unos cientos de pasos). Este retraso permite que el modelo “extraiga” cualquier información necesaria restante del token y la mix en el contexto precise antes de que el token se borre de la caché de KV.

“El mecanismo de ‘desalojo retrasado’ es essential porque no todos los tokens son simplemente ‘importantes’ (conservar para siempre) o ‘inútiles’ (eliminar inmediatamente). Muchos se encuentran en el medio: contienen cierta información, pero no la suficiente como para justificar la ocupación de un espacio completo en la memoria”, dijo Nawrot. “Aquí es donde radica la redundancia. Al mantener estos tokens en una ventana native durante un corto período de tiempo antes del desalojo, permitimos que el modelo los atienda y redistribuya su información en futuros tokens”.

Los investigadores descubrieron que este proceso de modernización es muy eficiente. Podrían equipar un LLM previamente capacitado con DMS en solo 1000 pasos de capacitación, una pequeña fracción de la computación requerida para la capacitación authentic. Los modelos resultantes utilizan núcleos estándar y pueden colocarse directamente en pilas de inferencia de alto rendimiento existentes sin necesidad de reescribir {hardware} personalizado ni software program complejo.

DMS en acción

Para validar la técnica, los investigadores aplicaron DMS a varios modelos de razonamiento, incluida la serie Qwen-R1 (destilada de DeepSeek R1) y Llama 3.2, y los probaron en puntos de referencia difíciles como AIME 24 (matemáticas), GPQA Diamond (ciencia) y LiveCodeBench (codificación).

Los resultados muestran que DMS mueve efectivamente la frontera de Pareto, el equilibrio óptimo entre costo y rendimiento. En la prueba comparativa matemática AIME 24, un modelo Qwen-R1 32B equipado con DMS logró una puntuación 12,0 puntos superior a un modelo estándar cuando se limitó al mismo presupuesto de ancho de banda de memoria. Al comprimir el caché, el modelo podría permitirse el lujo de “pensar” mucho más profundamente y más ampliamente que el modelo estándar con la misma memoria y presupuesto de computación.

Quizás lo más sorprendente es que DMS desafió la sabiduría común de que la compresión perjudica la comprensión del contexto a largo plazo. En las pruebas de “aguja en un pajar”, que miden la capacidad de un modelo para encontrar una información específica oculta en un documento grande, las variantes de DMS en realidad superaron a los modelos estándar. Al gestionar activamente su memoria en lugar de acumular ruido pasivamente, el modelo mantuvo un contexto más limpio y útil.

Para la infraestructura empresarial, las ganancias en eficiencia se traducen directamente en ahorros de rendimiento y {hardware}. Debido a que la memoria caché es significativamente más pequeña, la GPU dedica menos tiempo a buscar datos, lo que cut back el tiempo de espera de los usuarios. En las pruebas con el modelo Qwen3-8B, DMS igualó la precisión del modelo básico y ofreció un rendimiento hasta 5 veces mayor. Esto significa que un único servidor puede manejar cinco veces más consultas de clientes por segundo sin que la calidad disminuya.

El futuro de la memoria

Nvidia ha lanzado DMS como parte de su Biblioteca KVPress. En cuanto a cómo las empresas pueden empezar a utilizar DMS, Nawrot enfatizó que la barrera de entrada es baja. “La ‘infraestructura mínima viable’ son los canales estándar de Hugging Face; no se requieren núcleos CUDA personalizados”, dijo Nawrot, señalando que el código es totalmente appropriate con FlashAttention estándar.

De cara al futuro, el equipo ve a DMS como parte de un cambio más amplio en el que la gestión de la memoria se convierte en una capa distinta e inteligente de la pila de IA. Nawrot también confirmó que DMS es “totalmente appropriate” con arquitecturas más nuevas como la Atención latente de múltiples cabezas (MLA) utilizado en los modelos de DeepSeek, lo que sugiere que la combinación de estos enfoques podría generar ganancias de eficiencia aún mayores.

A medida que las empresas pasan de simples chatbots a complejos sistemas de agentes que requieren un razonamiento más amplio, el costo de la inferencia se está convirtiendo en una preocupación primordial. Técnicas como DMS proporcionan un camino para escalar estas capacidades de manera sostenible.

“Apenas hemos arañado la superficie de lo que es posible”, dijo Nawrot, “y esperamos que la escala del tiempo de inferencia evolucione aún más”.