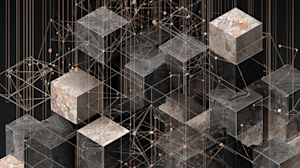

A kilómetros de distancia, al otro lado del desierto, la Gran Pirámide parece una geometría suave y perfecta: un triángulo elegante que apunta a las estrellas. Sin embargo, si te quedas en la base, la ilusión de suavidad se desvanece. Ves enormes bloques de piedra caliza dentados. No es una pendiente; es una escalera.

Recuerda esto la próxima vez que escuches a los futuristas hablar de crecimiento exponencial.

El cofundador de Intel, Gordon Moore (Ley de Moore), es famoso por decir en 1965 que el número de transistores en un microchip se duplicaría cada año. Otro ejecutivo de Intel, David Home, revisó más tarde esta declaración para “calcular que la potencia se duplica cada 18 meses”. Durante un tiempo, las CPU de Intel fueron el modelo de esta ley. Es decir, hasta que el crecimiento en el rendimiento de la CPU se aplanó como un bloque de piedra caliza.

Sin embargo, si nos alejamos, el siguiente bloque de piedra caliza ya estaba ahí: el crecimiento en la computación simplemente pasó de las CPU al mundo de las GPU. Jensen Huang, director ejecutivo de Nvidia, jugó un largo juego y resultó un gran ganador, construyendo sus propios peldaños inicialmente con los juegos, luego con la visión por computadora y, recientemente, con la IA generativa.

La ilusión de un crecimiento fluido

El crecimiento tecnológico está lleno de aceleraciones y estancamientos, y la generación de IA no es inmune. La ola precise está impulsada por la arquitectura transformadora. Para citar al presidente y cofundador de Anthropic, Dario Amodei: “El exponencial continúa hasta que deja de hacerlo. Y cada año hemos dicho: ‘Bueno, no es posible que las cosas continúen en el exponencial’, y luego todos los años así es”.

Pero justo cuando la CPU se estancó y las GPU tomaron la delantera, estamos viendo señales de que el crecimiento de los LLM está cambiando los paradigmas nuevamente. Por ejemplo, a finales de 2024, DeepSeek sorprendió al mundo al entrenar un modelo de clase mundial con un presupuesto increíblemente pequeño, en parte mediante el uso de la técnica MoE.

¿Recuerdas dónde viste recientemente que se mencionara esta técnica? Comunicado de prensa de Rubin de Nvidia: La tecnología incluye “… las últimas generaciones de tecnología de interconexión Nvidia NVLink… para acelerar la IA agente, el razonamiento avanzado y la inferencia de modelos MoE a gran escala a un costo por token hasta 10 veces menor”.

Jensen sabe que lograr ese codiciado crecimiento exponencial en computación ya no proviene de pura fuerza bruta. A veces es necesario cambiar la arquitectura por completo para colocar el siguiente trampolín.

La disaster de latencia: dónde encaja Groq

Esta larga introducción nos lleva a Groq.

Los mayores avances en las capacidades de razonamiento de la IA en 2025 fueron impulsados por el “cómputo del tiempo de inferencia” o, en términos sencillos, “dejar que el modelo piense durante un período de tiempo más largo”. Pero el tiempo es dinero. A los consumidores y a las empresas no les gusta esperar.

Groq entra en juego aquí con su inferencia a la velocidad del rayo. Si combina la eficiencia arquitectónica de modelos como DeepSeek y el gran rendimiento de Groq, tendrá inteligencia de vanguardia al alcance de su mano. Al ejecutar la inferencia más rápido, puede “superar la razón” de los modelos competitivos, ofreciendo un sistema “más inteligente” a los clientes sin la penalización del retraso.

Del chip common a la optimización de la inferencia

Durante la última década, la GPU ha sido el martillo common para cada clavo de la IA. Utiliza H100 para entrenar el modelo; utiliza H100 (o versiones recortadas) para ejecutar el modelo. Pero a medida que los modelos cambian hacia el pensamiento del “Sistema 2”, donde la IA razona, se autocorrige e itera antes de responder, la carga de trabajo computacional cambia.

El entrenamiento requiere una fuerza bruta paralela masiva. La inferencia, especialmente para los modelos de razonamiento, requiere un procesamiento secuencial más rápido. Debe generar tokens instantáneamente para facilitar cadenas de pensamiento complejas sin que el usuario espere minutos para obtener una respuesta. La arquitectura LPU (Unidad de procesamiento de lenguaje) de Groq elimina el cuello de botella del ancho de banda de la memoria que afecta a las GPU durante la inferencia de lotes pequeños, brindando una inferencia ultrarrápida.

El motor de la próxima ola de crecimiento

Para la C-Suite, esta posible convergencia resuelve la disaster de latencia del “tiempo para pensar”. Considere las expectativas de los agentes de IA: queremos que reserven vuelos de forma autónoma, codifiquen aplicaciones completas e investiguen precedentes legales. Para hacer esto de manera confiable, es posible que un modelo necesite generar 10,000 “tokens de pensamiento” internos para verificar su propio trabajo antes de enviar una sola palabra al usuario.

-

En una GPU estándar: 10.000 fichas de pensamiento pueden tardar entre 20 y 40 segundos. El usuario se aburre y se marcha.

-

En Groq: Esa misma cadena de pensamientos ocurre en menos de 2 segundos.

Si Nvidia integra la tecnología de Groq, solucionan el problema de “esperar a que el robotic piense”. Conservan la magia de la IA. Así como pasaron de renderizar píxeles (juegos) a renderizar inteligencia (IA de generación), ahora pasarían a renderizar razonamiento en tiempo actual.

Además, esto crea un formidable foso de software program. El mayor obstáculo de Groq siempre ha sido la pila de software program; El mayor activo de Nvidia es CUDA. Si Nvidia envuelve su ecosistema alrededor del {hardware} de Groq, efectivamente cavarán un foso tan amplio que los competidores no podrán cruzarlo. Ofrecerían la plataforma common: el mejor entorno para entrenar y el entorno más eficiente para ejecutar (Groq/LPU).

Considere lo que sucede cuando combina ese poder de inferencia en bruto con un modelo de código abierto de próxima generación (como el rumoreado DeepSeek 4): obtiene una oferta que rivalizaría con los modelos de vanguardia actuales en costo, rendimiento y velocidad. Esto abre oportunidades para Nvidia, desde ingresar directamente al negocio de la inferencia con su propia oferta de nube, hasta continuar impulsando a un número creciente de clientes en crecimiento exponencial.

El siguiente paso en la pirámide

Volviendo a nuestra metáfora inicial: el crecimiento “exponencial” de la IA no es una línea fluida de fracasos brutos; es una escalera de cuellos de botella que se están rompiendo.

-

Bloque 1: No pudimos calcular lo suficientemente rápido. Solución: La GPU.

-

Bloque 2: No pudimos entrenar lo suficientemente profundo. Solución: Arquitectura transformadora.

-

Bloque 3: No podemos “pensar” lo suficientemente rápido. Solución: LPU de Groq.

Jensen Huang nunca ha tenido miedo de canibalizar sus propias líneas de productos para adueñarse del futuro. Al validar Groq, Nvidia no sólo estaría comprando un chip más rápido; estarían llevando inteligencia de próxima generación a las masas.

Andrew Filev, fundador y director ejecutivo de Zencoder

¡Bienvenido a la comunidad VentureBeat!

Nuestro programa de publicaciones invitadas es donde los expertos técnicos comparten conocimientos y brindan análisis profundos neutrales y no adquiridos sobre inteligencia synthetic, infraestructura de datos, ciberseguridad y otras tecnologías de vanguardia que dan forma al futuro de las empresas.

Leer más de nuestro programa de publicaciones de invitados y consulte nuestro pautas ¡Si estás interesado en contribuir con un artículo propio!